Hvorfor ChatGPT Talks the Talk, men ikke Walk the Walk

Av Matthias Ramaekers

Menneskelig intelligens forblir unik sammenlignet med den såkalte intelligensen til store språkmodeller.

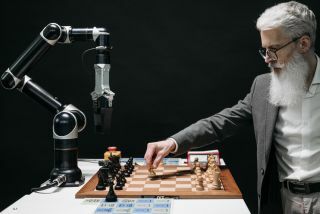

Kilde: Pavel Danilyuk / Pexels

Det har du sikkert lagt merke til kunstig intelligens (AI)-forskning er en blomstrende virksomhet. Nylige fremskritt innen store språkmodeller (LLM), som den som driver ChatGPT, overrasket verden.

Deres evne til menneskelignende språk og problemløsningsevner førte til at mange forestilte seg potensielle bruksområder eller risikoer for samfunnet – inkludert Geoffrey Hinton, «gudfaren til AI».

Andre påpekte at LLM-er har relativt begrenset kapasitet til aktiviteter som mennesker utfører med liten innsats, som f.eks. humor [1], årsaks- og kontrafaktisk resonnement [2], og logikk [3]. Så i hvilken grad etterligner disse modellene virkelig menneskelige, eller faktisk generelle, intelligens?

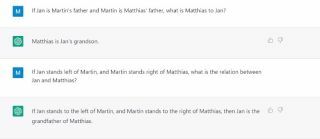

Figur 1 GPT 3.5 mislykkes i et enkelt relasjonsproblem, tilsynelatende fordi det ble undersøkt på et strukturelt lignende, men semantisk urelatert problem.

Kilde: Mattias Ramaekers

Å svare på det spørsmålet krever en definisjon av intelligens, men det er mye debatt om hvordan man definerer intelligens, enten menneskelig eller kunstig intelligens [4-5]. Når jeg overlater disse debattene til siden, vil jeg fokusere på en egenskap ved intelligente systemer som mine kolleger i Læring og implisitte prosesser Lab er interessert i: evnen til å lære, det vil si å endre atferd som en funksjon av tidligere erfaringer [6].

Mennesker og mange andre organismer er i stand til å lære [7]. Mange lærepsykologer som meg ville vært uten jobb hvis de ikke var det. LLM-er som det under panseret til ChatGPT lærer også av erfaringer med forskjellige læringsalgoritmer.

Hvordan sammenligner vi disse systemene? Vi kan skille dem med tanke på hastigheten og effektiviteten de lærer og fleksibiliteten og kreativitet der de anvender lært kunnskap. Vi ser nå betydelige forskjeller mellom mennesker, andre dyr og kunstige systemer.

Når det gjelder hastighet, har mennesker en klar fordel fremfor topp moderne AI. Kort sagt, LLM-er er trent på enorme mengder data, hvorfra de i hovedsak lærer å forutsi hvilke (deler av) ord som er mest sannsynlige å følge tidligere (deler av) ord, etterfulgt av en andre runde med trening for å finjustere svarene deres på menneskeskapte meldinger og spørsmål.

Denne læringshistorien er tilstrekkelig til å produsere bemerkelsesverdig menneskelignende svar. Likevel krever LLM-er vanligvis omtrent fire til fem størrelsesordener, eller omtrent 50 000 ganger flere treningsinstanser enn det gjennomsnittlige menneskelige barnet, for å produsere den oppførselen [8]. ChatGPTs trening er en ganske brutal tilnærming til å lære å produsere intelligent språklig atferd. Det lar det fange opp de underliggende regelmessighetene til menneskelig språk, men det skiller seg betydelig fra hvordan mennesker tilegner seg språk.

Mennesker er ikke bare raskere, men også mer fleksible. Barn tilegner seg raskt evnen til å resonnere om nye problemer fleksibelt og tilpasse seg nye situasjoner etter bare noen få eksponeringer eller ren instruksjon.

Denne bragden er fortsatt en utfordring for toppmoderne AI. LLM-er har mye forbedret generaliseringskapasitet, men det er vanskelig å systematisk vurdere fordi opplæringen deres omfatter praktisk talt alt mennesker noen gang har skrevet. Når du undersøker nye problemer eller tilfeller av kjente problemer, kan du se grensene for dens evner, å foreslå svarene gjenspeiler noe som ligner mer på å huske problemløsninger enn grundig forståelse.

Et annet eksempel på at GPT3.5 svikter et enkelt relasjonsproblem. Resonnementet er riktig, men det kommer da til en feilaktig (eller i hvert fall ikke nødvendigvis riktig) konklusjon.

Kilde: Mattias Ramaekers

Nåværende LLM-er er ikke en ideell modell for læringspsykologer som undersøker hvordan mennesker lærer. Hva er det da som gjør mennesker så unike?

I laboratoriet vårt tar vi perspektivet til relasjonsrammeteori (RFT) [9], som foreslår at mennesket kognisjon, og dermed intelligens, er basert på vår evne til relasjonell respons – å reagere på en hendelse når det gjelder dens forhold til en annen.

Når vi vokser opp i et verbalt, sosialt fellesskap, lærer vi å relatere gjenstander og hendelser i miljøet vårt på mange måter (A er det samme som B, A er mer enn B, A er mindre enn B, A er en del av B, A kommer etter B, A er her og B er der, A er til B som C er til D, og så videre). Vi lærer også å svare på disse relasjonene på riktig måte (f.eks. hvis boks A har én sjokolade, og boks B har mer enn boks A, hvilken velger du?). Over tid kan relasjonene abstraheres bort fra de irrelevante fysiske egenskapene til de relaterte objekter, og vi kan begynne å bruke dem på objekter vilkårlig eller symbolsk (f.eks. reagere på ordet "hund" på samme måte som en hund).

Denne evnen til å "handle som om" ting henger sammen gir grunnlaget for rask, fleksibel og generativ læring og, til syvende og sist, det vi anser for å være intelligent oppførsel (se [10] for flere eksempler). Det er ingen tilfeldighet at mange av deltestene som utgjør moderne intelligenstester (f.eks. Ravens progressive matriser og andre flytende resonnementstester, verbal resonnement, visuospatial resonnement, etc.) vurdere atferd som er relasjonell og at det er foreløpige bevis som tyder på at relasjonell trening kan hjelp øke barns intelligens [11]

Artificial Intelligence Essential Reads

Selvfølgelig erkjenner mange i AI viktigheten av relasjonelle resonnementer og har forsøkt å inkorporere relasjonsmekanismer i modellene sine. Så langt ser det imidlertid ut til at ingen har nådd det "symbolske nivået" som fortsatt er unikt okkupert av mennesker. Anta at AI-forskning ønsker å speile prosessene som ligger til grunn for menneskelige evner og ikke bare produsere menneskelignende resultater som nå.

I så fall vil det kreve en annen tilnærming fokusert på effektiv, kontekstsensitiv læring. I mitt søk i LIP-laben prøver vi å gjøre dette ved å utvikle beregningsmodeller inspirert av kjerneideene til RFT, som, hvis teorien er riktig, skulle gi en bedre (dvs. raskere og mer fleksibel) modell av mennesket læring.

For å gå tilbake til spørsmålet om ChatGPTs intelligens, er det viktig å merke seg at det ble utviklet med en spesifikk formål: å samhandle med mennesker gjennom et datamaskingrensesnitt og produsere sammenhengende svar på hva som helst får. Med det målet i tankene er ytelsen bemerkelsesverdig.

Den ble ikke designet for å være generelt intelligent (dvs. i stand til fleksibelt å tilpasse seg nye situasjoner eller problemer), og det er den ikke. Likevel gir den oss en illusjon av intelligens fordi den etterligner intelligent menneskelig språk.

Matthias Ramaekers er forsker ved Learning and Implicit Processes Lab. Forfatteren ønsker å takke Jan De Houwer og Martin Finn for deres tilbakemeldinger på tidligere versjoner.